Toutes les entreprises qui se sont essayées à mettre en œuvre un projet d’IA ont démarré par les mêmes étapes: la collecte des données et la mise en place d’une plate-forme de Machine Learning. Ces travaux sont nécessaires, ils consomment de la ressource IT, nécessitent de l’expertise et ce n’est qu’une fois qu’ils ont été effectués que les Data Scientists peuvent intervenir. Ainsi, la majorité des investissements réalisés sur des projets d’IA concernent des activités non directement liées à l’IA. L’approche «Do it yourself» n’est pas la mieux adaptée en termes de retour sur investissement.

Des ETL classiques mal adaptés à la collecte des données

Beaucoup plus que les algorithmes, les données sont le facteur-clé de succès d’un projet d’IA. En effet, mieux vaut avoir beaucoup de données de qualité analysées avec des algorithmes basiques qu’un jeu de données pauvre analysé avec des algorithmes puissants. Or, la préparation des données pour une analyse IA est très différente de celle qui conduit à la construction d’un Datawarehouse ou de Datamarts. L’idée lors de la phase d’analyse sera notamment de trouver des corrélations qui ne sont a priori pas évidentes.

Les outils d’ETL habituellement utilisés par les entreprises, qui ont été construits avant l’avènement des environnements Big Data, ne sont pas du tout adaptés.

Aussi, il est nécessaire de compléter les données métiers générées par le SI de l’entreprise par des données liées venant de l’environnement: réseaux sociaux, indices financiers, images satellites, conditions météorologiques, etc., le tout sur une période de temps la plus représentative possible. Les volumes sont potentiellement énormes, d’autant plus que les données métiers elles-mêmes sont souvent combinées et dupliquées. Les technologies existent aujourd’hui pour gérer ces volumes (Hadoop, Elasticsearch…) mais les outils d’ETL habituellement utilisés par les entreprises, qui ont été construits avant l’avènement des environnements Big Data, ne sont pas du tout adaptés.

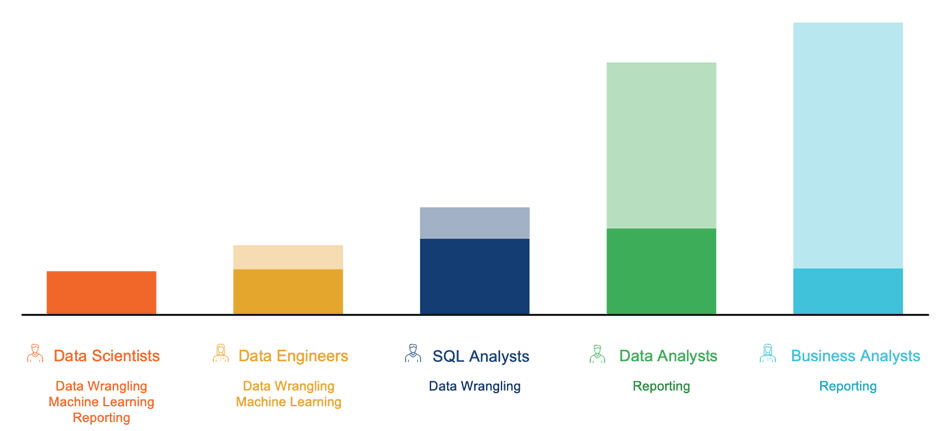

Une nouvelle génération d’outils de Data Wrangling construite directement avec les technologies Big Data est aujourd’hui disponible. Ces outils permettent d’effectuer toutes les étapes du Data Wrangling* en Self Service beaucoup plus rapidement et efficacement qu’avec un ETL. Les utilisateurs, qui sont soit des Data Scientists, soit des experts métiers, utilisent une interface très proche d’Excel, pour manipuler en temps réel une extraction des données sources, définir des règles ou appliquer des macros qui seront ensuite déployées dans un environnement de collecte le plus souvent basé sur Hadoop.

(Illustration: InTech)

est probablement aujourd’hui la plate-forme la plus avancée sur ce sujet. Chez InTech, nous l’avons mise en œuvre chez plusieurs clients à Luxembourg avec des résultats très concluants: diminution du temps de préparation des données, mise en place de boucle de rétroaction et amélioration de la réactivité, implication ciblée et efficace des IT internes.

Vers une industrialisation de l’analyse des données

Une fois les données préparées et publiées, il faut les analyser. L’utilisation d’intelligence artificielle pour analyser les données impose la mise en place de plates-formes spécifiques dédiées. L’étape préalable à l’analyse proprement dite consiste donc à installer ces outils qui ne sont que très rarement déjà déployés dans les SI des grandes entreprises et mettre en œuvre Python, Scala et Spark nécessite une expertise spécifique. Ce sont plusieurs jours et plusieurs milliers voire dizaines de milliers d’euros qui sont nécessaires à l’installation de ces outils on-premisses, sans que cela n’apporte à ce stade la moindre valeur ajoutée métier.

Il faut ensuite imaginer et tester les modèles d’analyse, puis les tester sur les données réelles. Une fois que le ou les bons modèles ont été trouvés, il faut en industrialiser l’exécution et les déployer dans l’environnement de production. Ces étapes nécessitent souvent de nombreuses itérations avant de trouver le modèle qui réponde précisément au cas d’utilisation imaginé.

L’utilisateur choisit la meilleure combinaison en fonction de la nature du business case.

Ici encore, le temps passé sur des activités qui ne sont pas spécifiques au métier n’est pas négligeable, et ici encore, des éditeurs proposent des plates-formes «out of the box» qui permettent de travailler sur les données dès qu’elles sont disponibles. DataRobot est probablement la plus avancée d’entre elles. Une fois une première passe d’analyse générique effectuée sur les données pour déterminer leur type et leur répartition statistique et après une première configuration sommaire de la part du Data Scientist, ce sont plusieurs dizaines de modèles de Machine Learning préconfigurés par les ingénieurs de DataRobot qui sont exécutés en parallèle sur les données pour permettre de choisir lequel sera utilisé en production. L’utilisateur choisit la meilleure combinaison (temps d’exécution)/(précision des résultats) en fonction de la nature du business case. Le modèle choisi est déployé en production est peut-être déclenché à la demande par API ou en fonction d’un événement précis.

Quel rôle pour une IT interne?

Ainsi, il est d’ores et déjà possible de mettre en œuvre des processus complets d’analyse de données en utilisant des plates-formes industrielles dédiées et en impliquant les utilisateurs métiers dès le début du projet. Quel est le rôle d’une IT interne dans ce contexte? L’intégration au SI de l’entreprise de ces nouvelles générations de plates-formes, si elle peut être rapide, nécessite une expertise pointue tant concernant le SI existant que sur les principes mis en œuvre (Hadoop, apprentissage supervisé ou non, Deep Learning…). L’IT interne peut également être l’entité organisationnelle qui forme et gère les Data Scientists qui doivent garder un rôle transverse dans l’organisation et pouvoir proposer leurs services à toutes les lignes métier, tout comme les développeurs aujourd’hui.

*Data Wrangling: Le Data Wrangling est le processus qui permet, à partir des données brutes, de les découvrir, structurer, nettoyer, enrichir, valider et de publier les résultats dans un format adapté à l’analyse des données.