«Pancho», comme l’ont baptisé les chercheurs qui ont travaillé avec lui, était incapable de parler depuis 16 ans. Depuis ce double accident, de voiture et cérébral et vasculaire, qui l’a réduit à des grognements, sans qu’il n’ait affecté ses yeux. C’est à partir de cette particularité que l’équipe californienne a pu mettre en place un dispositif inédit.

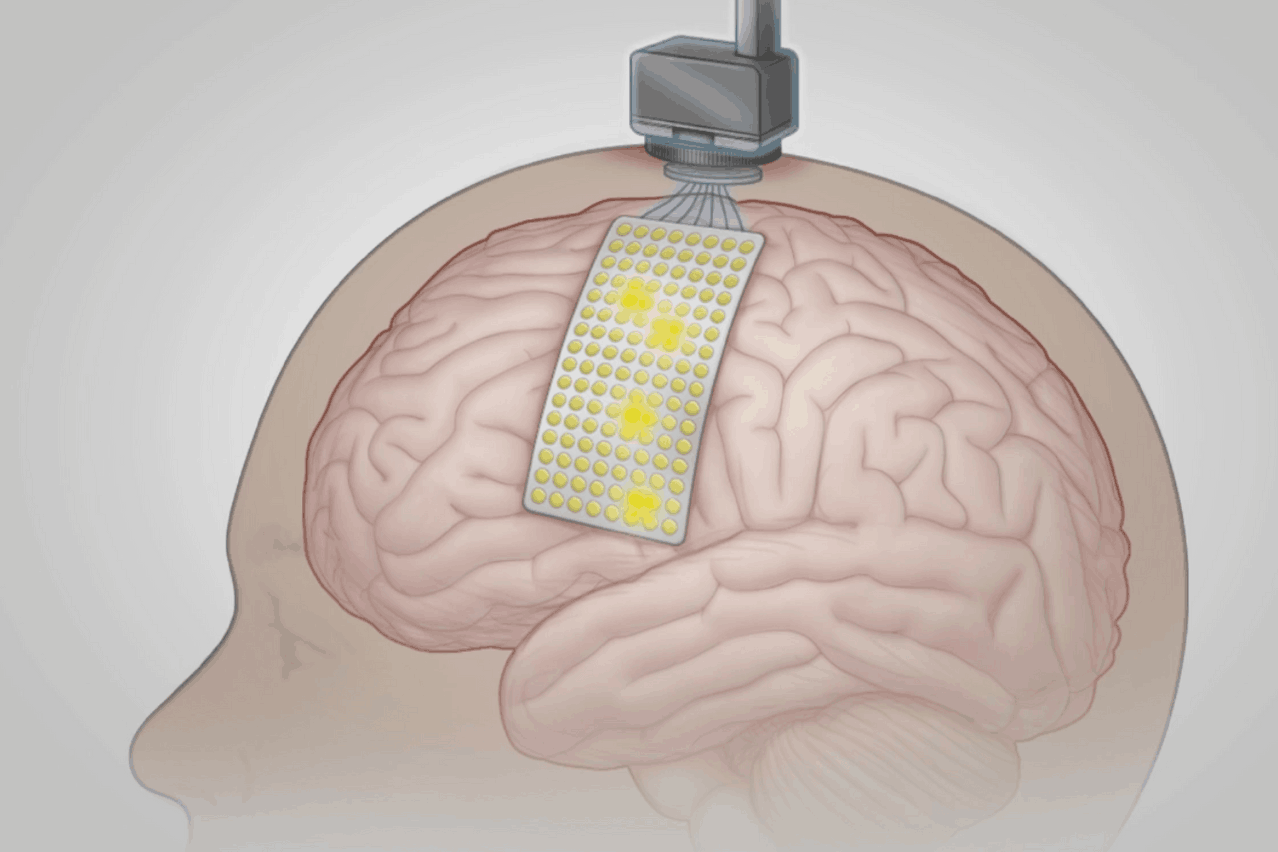

128 électrodes ont été installées sur son crâne au cours d’une opération de trois heures en février 2019. «Au cours de 48 sessions, nous avons enregistré 22 heures d’activité corticale pendant que le participant tentait de dire des mots individuels à partir d’un ensemble de vocabulaire de 50 mots. Nous avons utilisé des algorithmes d’apprentissage en profondeur pour créer des modèles informatiques pour la détection et la classification de mots à partir de modèles dans l’activité corticale enregistrée. Nous avons appliqué ces modèles informatiques, ainsi qu’un modèle de langage naturel qui a donné des probabilités de mots en fonction des mots précédemment utilisés dans une séquence, pour décoder des phrases complètes au fur et à mesure que le participant tentait de les prononcer.»

Il devait tenter de dire des mots d’une liste de 50 mots, y compris des mots que suggéraient les chercheurs, et, dans d’autres expériences, de dire des phrases. Les données collectées au cours des deux types d’exercice ont permis de nourrir une intelligence artificielle qui a permis, en fin de compte, de mieux analyser ce que le patient voulait dire.

Le «Hungry, how am you» que la machine avait détecté au début pouvait ainsi devenir «Hello, how are you», une fois le calibrage effectué correctement. Des milliers de tentatives pour s’assurer que la machine pouvait transcrire correctement ce que le patient voulait dire.

«C’est plus loin que nous n’avions jamais imaginé pouvoir aller», a déclaré Melanie Fried-Oken, professeur de neurologie et de pédiatrie à l’Oregon Health & Science University, qui n’était pas impliquée dans le projet, raconte le New York Times, qui s’est fait l’écho de cette étude publiée dans le New England Journal of Medicine.

Dans un article de blog, Facebook a déclaré qu’il mettait fin à son projet Neuralink et se concentrerait plutôt sur un contrôleur de poignet expérimental pour la réalité virtuelle qui lit les signaux musculaires dans le bras. «Alors que nous croyons toujours au potentiel à long terme des technologies optiques [interface cerveau-ordinateur] montées sur la tête, nous avons décidé de concentrer nos efforts immédiats sur une approche d’interface neuronale différente qui a un chemin à plus court terme vers le marché», .